Imaginez : vous êtes en train de taper une question absurde sur votre téléphone, genre "Comment faire un gâteau au chocolat avec des ingrédients improbables ?", et boum, l'IA vous pond une recette en deux secondes. Magique, non ? Mais attendez, ce n'est pas de la sorcellerie. C'est une bataille féroce pour des puces électroniques qui dévorent de l'énergie comme si demain n'existait pas. Et si je vous disais que cette "guerre des puces" pourrait changer notre monde plus que vous ne l'imaginez ?

Voici le truc : l'IA n'est pas juste un gadget cool. Elle bouffe de la puissance de calcul à un rythme dingue, et ça pose des questions sérieuses sur notre avenir tech.

Quand les neurones artificiels deviennent gloutons

Pensez à votre cerveau. Il tourne avec l'équivalent d'une ampoule de 20 watts, et pourtant, il gère vos souvenirs, vos émotions, et même ce café que vous avez renversé ce matin. Les IA, elles ? Pas du tout. Pour entraîner un modèle comme GPT-3, il a fallu 1 287 mégawatt-heures d'énergie – assez pour alimenter 120 foyers américains pendant un an. C'est fou, hein ?

Pensez à votre cerveau. Il tourne avec l'équivalent d'une ampoule de 20 watts, et pourtant, il gère vos souvenirs, vos émotions, et même ce café que vous avez renversé ce matin. Les IA, elles ? Pas du tout. Pour entraîner un modèle comme GPT-3, il a fallu 1 287 mégawatt-heures d'énergie – assez pour alimenter 120 foyers américains pendant un an. C'est fou, hein ?

Et ça empire. Les besoins en calcul pour l'IA doublent tous les cinq mois environ. Pourquoi ? Parce que les modèles grossissent. Plus de données, plus de paramètres, plus de complexité. Prenez un simple chat avec ChatGPT : chaque requête consomme environ 0,3 watt-heure. Multipliez ça par des milliards d'utilisateurs, et vous avez une facture énergétique qui explose.

Vous vous demandez probablement : "Mais pourquoi tant de haine pour l'électricité ?" C'est simple. L'IA adore les tâches parallèles – comme analyser des millions d'images en même temps. Les processeurs classiques, genre ceux de votre laptop, sont nuls pour ça. D'où l'essor des GPU, ces bêtes de course conçues pour le gaming mais recyclées pour l'IA.

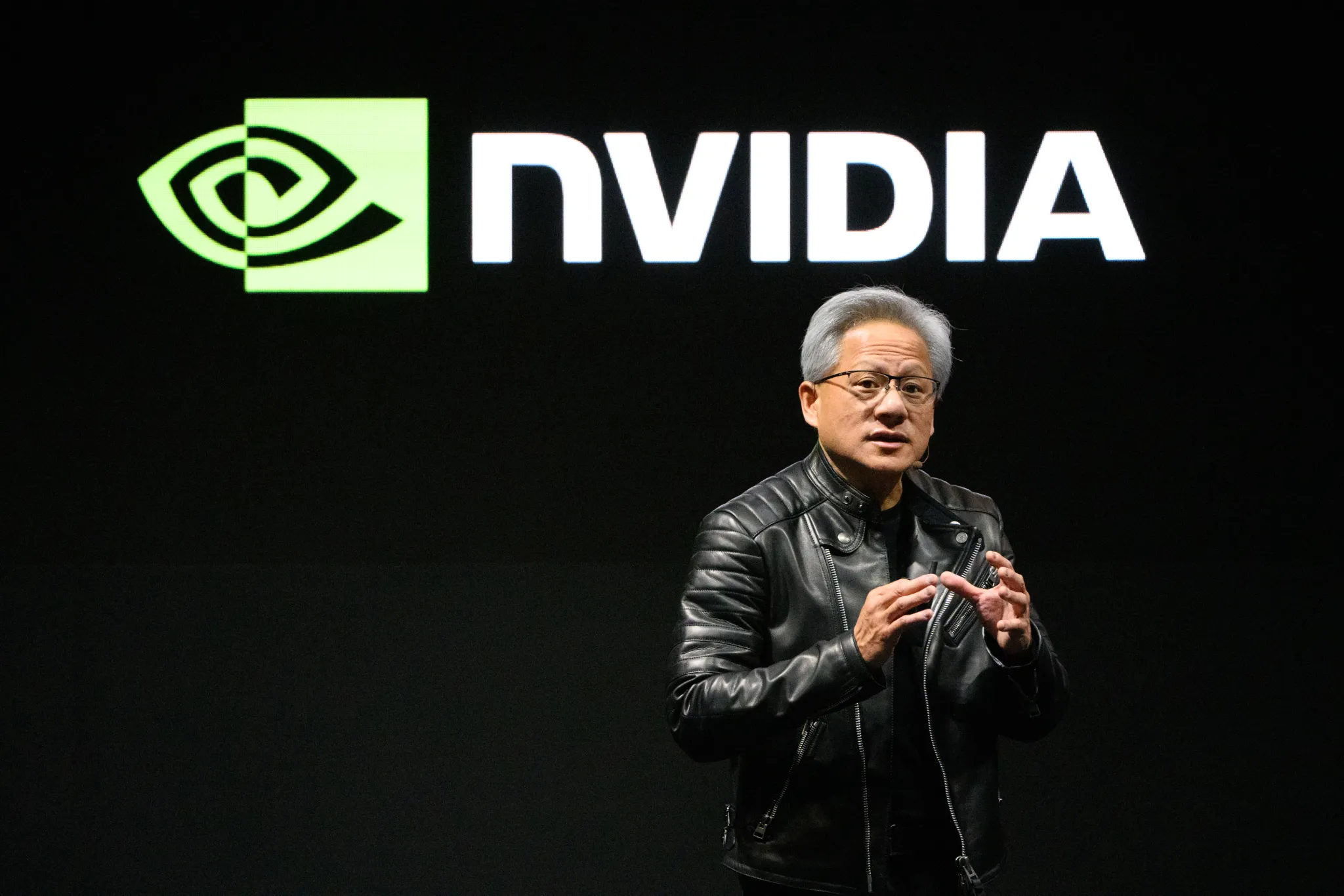

NVIDIA : le shérif de la ville, avec des challengers à l'horizon

Parlons cash. NVIDIA domine le game. Avec 80 à 90 % du marché des puces pour l'IA, c'est le roi incontesté. Leurs GPU, comme les séries A100 ou H100, sont partout : chez OpenAI pour entraîner GPT, chez Meta pour ses algos de recommandation. Pourquoi eux ? Parce que leur logiciel CUDA est une forteresse – facile à utiliser, optimisé à mort.

Mais attendez, plot twist : les concurrents se réveillent. AMD pousse avec ses MI300, taillés pour l'IA, et grignote des parts de marché. Google, pas en reste, déploie ses TPUs maison, ces puces custom qui font trembler NVIDIA. Imaginez Meta qui passe à des TPUs pour ses modèles – ça a fait chuter l'action NVIDIA de 4 % en une journée !

Voici ce qui se passe vraiment : cette guerre n'est pas que sur la puissance brute. C'est sur l'efficacité. NVIDIA vend des puces comme des petits pains, mais les géants du cloud comme Google veulent leur indépendance. Et Intel ? Ils reviennent dans la danse avec des chips hybrides, mais franchement, ils sont encore en mode rattrapage.

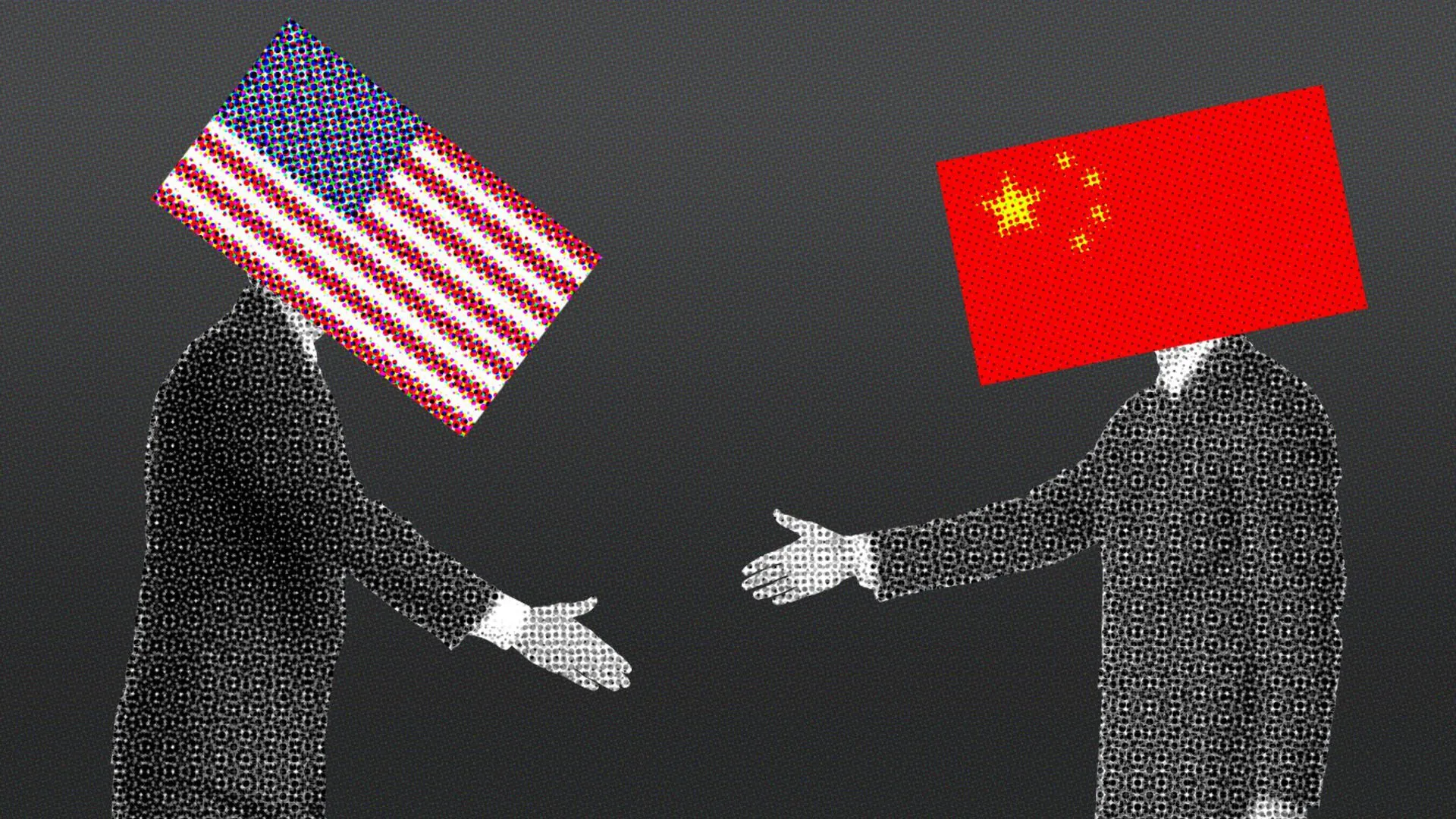

La bataille US-Chine qui pourrait stopper l'IA en plein vol

Qui sortira vainqueur ?

Allons dans le géopolitique. La "guerre des puces" n'est pas une métaphore – c'est réel. En 2024-2025, les US ont renforcé les contrôles d'export sur les semi-conducteurs avancés vers la Chine, selon un rapport du Congrès US. Résultat ? La Chine, qui dépendait à 95 % de NVIDIA pour ses puces IA en 2023, vise maintenant 55 % d'autosuffisance d'ici 2027.

Plot twist : ça booste les champions chinois comme Huawei, qui développe ses propres chips. Mais TSMC, basé à Taïwan, reste indispensable – ils fabriquent les puces Blackwell de NVIDIA, avec production démarrant en Arizona en 2025, mais packaging final en Taïwan. Bloomberg rapporte que les US déploient tarifs et contrôles pour freiner la Chine, tandis que l'Europe et les US unissent forces contre Pékin, comme le note CEPA en 2025.

Si cette guerre s'intensifie, les prix des puces IA pourraient grimper de 20-30 %, impactant tout, de ton smartphone à les outils comme Midjourney. En 2025, des enquêtes comme celle de CSIS montrent les limites de ces contrôles : la Chine avance quand même.

L'inconfortable vérité : l'IA nous pompe notre planète

Personne ne veut l'admettre, mais voilà : l'IA est une vampire énergétique. En 2025, les data centers pour l'IA pourraient déjà exiger 10 gigawatts de puissance, et grimper à 327 GW d'ici 2030. C'est comme alimenter une petite nation entière, juste pour que votre assistant vocal vous dise la météo.

Pire encore, former un gros modèle IA pourrait bouffer plus de 4 GW à lui seul d'ici 2030. Et globalement ? Les data centers représentaient 4 % de la conso électrique US en 2024, et ça pourrait doubler d'ici 2030. Oubliez ce qu'on vous raconte sur les "IA vertes" – pour l'instant, c'est du greenwashing. L'IA pourrait consommer autant d'électricité que 22 % des foyers américains annuellement.

Son familier ? C'est comme la crypto il y a quelques années : hype maximale, impact environnemental monstrueux. Mais ici, c'est pire, parce que l'IA est partout. Des frigos intelligents aux voitures autonomes, tout demande plus de jus.

Et si on challengeait l'idée que "plus de puissance = meilleure IA" ? Beaucoup pensent que scaler les modèles résout tout. Faux. Des chercheurs montrent que l'efficacité logicielle pourrait réduire la conso de moitié, sans sacrifier la performance. Pourquoi pas miser sur des algos plus malins plutôt que des data centers géants ?

Pourquoi tout le monde se trompe sur la bulle IA

Vous savez ce qui est intéressant ? Tout le monde parle de cette "course à l'armement" comme si c'était inévitable. Mais écoutez les voix contraires : certains, comme Michael Burry (oui, le mec de The Big Short), prédisent une bulle qui va éclater. Trop d'argent investi – 7 trillions de dollars projetés pour les data centers d'ici 2030 – pour des retours pas toujours clairs.

Laissez-moi être direct : on est peut-être en train de surinvestir. Des experts disent que l'IA n'augmente pas encore la productivité comme promis. Prenez un programmeur : l'IA l'aide à coder plus vite, mais s'il passe son temps à debugger les erreurs de l'IA ? Pas de gain net.

Pourtant, d'autres voient ça comme les débuts. "On est encore aux premières manches de la mégatrend IA", disent les optimistes. Et si la vraie révolution était dans la "générative science" – utiliser l'IA pour des découvertes scientifiques, pas juste des memes ?

Voici la partie que personne ne vous dit : cette guerre des puces pourrait freiner l'innovation. Si seuls les géants comme NVIDIA ou Google peuvent se payer les infrastructures, où est la place pour les startups ? L'inégalité tech s'aggrave, et ça, c'est l'inconfortable vérité.

Prenez OpenAI. Pour entraîner GPT-4, ils ont cramé une énergie folle, probablement des milliers de GPU NVIDIA en parallèle. Résultat ? Un modèle qui écrit des poèmes, code des apps, et même diagnostique des maladies. Cool, mais à quel prix ?

Prenez OpenAI. Pour entraîner GPT-4, ils ont cramé une énergie folle, probablement des milliers de GPU NVIDIA en parallèle. Résultat ? Un modèle qui écrit des poèmes, code des apps, et même diagnostique des maladies. Cool, mais à quel prix ?

Ou Google avec ses TPUs. Ils les utilisent pour tout : recherche web, traduction, même pour optimiser leurs propres data centers. C'est malin – ils réduisent la dépendance à NVIDIA tout en boostant l'efficacité.

Et vous ? Imaginez votre entreprise. Si vous lancez une startup IA, vous commencez par louer des GPU sur AWS ou Azure. Mais les coûts explosent : des milliards investis en 2025 par les hyperscalers pour l'IA. Son familier pour les entrepreneurs qui galèrent déjà ?

Vers un futur où les puces sauvent le monde... ou pas

Oubliez ce que vous avez entendu sur les "limites physiques". Moore's Law ralentit, mais l'IA pousse plus vite – deux fois plus vite, même. Du coup, on innove : puces quantiques, neuromorphiques, qui imitent le cerveau humain pour moins d'énergie.

Mais plot twist : et si l'IA nous aidait à résoudre le problème énergétique ? Des modèles qui optimisent les réseaux électriques, prédisent les pannes, ou conçoivent des batteries meilleures. C'est possible – Google l'utilise déjà pour refroidir ses data centers plus efficacement.

Pourtant, nobody wants to admit this, but... on risque une pénurie d'énergie. Les US pourraient avoir besoin de 100 GW supplémentaires d'ici 2030 pour l'IA. Et si on n'investit pas dans les renouvelables, bonjour les blackouts.

Vous êtes probablement en train de penser : "OK, passionnant, mais qu'est-ce que j'y gagne ?" Eh bien, pour les pros : apprenez CUDA ou les TPUs, c'est l'avenir. Pour les étudiants : plongez dans l'IA hardware, il y a des jobs en or. Entrepreneurs ? Cherchez des niches éco-friendly, comme des IA low-power pour l'IoT.

Voici ce qui arrive vraiment : cette guerre des puces force tout le monde à repenser la tech. Plus de puissance, oui, mais intelligente. L'IA n'a pas besoin de plus de muscles, mais de plus de cerveau.

Et si la vraie question était : êtes-vous prêt à troquer un peu d'énergie pour un monde où l'IA guérit des maladies ou pilote des villes entières ? Ou est-ce qu'on freine avant que la facture ne devienne insurmontable ? À vous de jouer.